В этой статье опишу примерный план установки ollama на ОС Ubuntu. Ниже в таблице опишу примерные характеристики машины, на котором будет работать ИИ

| Параметр | Значение |

| ОС | Ubuntu 24.1 |

| CPU | i7-9750H CPU @ 2.60GHz |

| RAM | 16 Gb |

| SSD | 250 Gb |

| GPU | NVIDIA GeForce GTX 1050 |

| CUDA ядра | 768 |

| GPU память | 3072 Mb |

Установка Ollama

Ollama — это бесплатная нейронка с открытым исходным кодом, которое позволяет запускать различные большие языковые модели, включая Llama 3, на вашем собственном компьютере даже при ограниченных ресурсах.

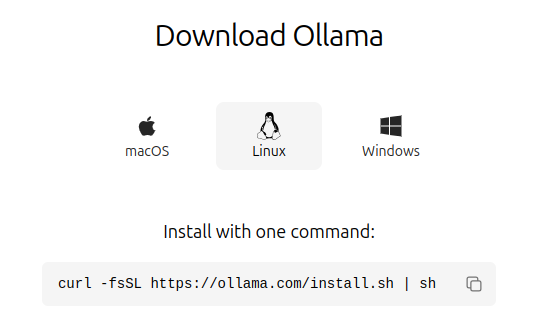

Первый шаг — установка Ollama. Ollama поддерживает все три основные операционные системы, но нам будет необходима секция установки для Linux

вставляем указанную команду

curl -fsSL https://ollama.com/install.sh | shпосле окончания установки в системе будут доступнык команды сервиса ollama и в первую очередь надо будет загрузить модель и для загрузки достаточно выполнит команду

ollama run llama3эта команда проверит наличие данной модели м запустит в интерактивном режиме и если ее нет, то сначала загрузит. Список остальных доступных моделей можно посмотреть на странице, а список загруженных в систему моделей можно посмотреть командой

ollama listУстановка Docker

Установка Docker не должно у вас составить труда и его тонкости установки не входят в перечень данной статьи, потому что это подробно описано в официальной документации.

Установка Open WebUI

Open WebUI — это расширяемый, многофункциональный и удобный для пользователя самостоятельный интерфейс AI, разработанный для работы полностью в автономном режиме. Он поддерживает различные LLM-раннеры, включая Ollama и API, совместимые с OpenAI.

Для установки данного интерфейса будем воспользоваться его контейнеризированной версией в Docker, который мы устанвоили в предыдущей секции.

При установке стандартным способом под Linux с их официальной страницы у вас могут быть проблемы, связанные с тем, что ранее устанволенные в системе модели Ollama не распознаются данным интерефейсом и не показываются в списке для выбора. Чтобы это решить нужно сделать пару шагов настройки.

Настройка Nvidia

Основная проблема тут связана с недсотающим набором инструментов nvidia-ctk, который придется установить

curl -fsSL https://nvidia.github.io/libnvidia-container/gpgkey | sudo gpg --dearmor -o /usr/share/keyrings/nvidia-container-toolkit-keyring.gpg && curl -s -L https://nvidia.github.io/libnvidia-container/stable/deb/nvidia-container-toolkit.list | sed 's#deb https://#deb [signed-by=/usr/share/keyrings/nvidia-container-toolkit-keyring.gpg] https://#g' | sudo tee /etc/apt/sources.list.d/nvidia-container-toolkit.list

sudo sed -i -e '/experimental/ s/^#//g' /etc/apt/sources.list.d/nvidia-container-toolkit.list

sudo apt-get update

sudo apt-get install -y nvidia-container-toolkit

sudo nvidia-ctk runtime configureдля запуска nvidia в контейнере придется установить

sudo apt-get install -y nvidia-docker2

sudo systemctl restart dockerдалее нам надо будет узнать идентификатор видеокарты

nvidia-smi -Lэто выведет примерный текст

GPU 0: NVIDIA GeForce RTX 1050 (UUID: GPU-3cc92aa5-19c8-aabe-3e76-fc23af770969)копируем данный идентификатор и запускаем WebUI командой

docker run -d --network=host --runtime=nvidia --gpus device=GPU-3cc92aa5-19c8-aabe-3e76-fc23af770969 -v ollama:/root/.ollama -v open-webui:/app/backend/data -e OLLAMA_BASE_URL=http://127.0.0.1:11434 --name open-webui --restart always ghcr.io/open-webui/open-webui:ollama

через, примерно, минуту панель будет загружена и запушена на порту localhost:8080 и в верхнем левом углу в списке появится загруженная ранее модель